Д.С. Чернавский — профессор, ФИАН РАН

Слово — «синергетика» в переводе с греческого означает «совместное действие». Предложил этот термин профессор Штудгартского университета Герман Хакен в 1978г. По существу синергетика состоит из математических моделей явлений самоорганизации. Таким образом история повторилась: сама наука появилась раньше чем «слово» ее обозначающее. Тем не менее это «слово» тоже сыграло положительную роль в интеграции наук (как ценная условная информация). В данном случае интеграция произошла на более высоком профессиональном уровне, поскольку человек, не владеющий математикой, синергетиком считаться не может. Сейчас слова «синергетика» и «самоорганизация» часто выступают как синонимы.

Глава 1.

ОСНОВНЫЕ ПОНЯТИЯ ДИНАМИЧЕСКОЙ ТЕОРИИ ИНФОРМАЦИИ

Сейчас имеется несколько (даже много) определений понятия «информация» и ни одно из них не является общепринятым. Это естественно, поскольку общепризнанные определения появляются в науке, когда она становится классической и перестает развиваться. О науке об информации этого, к счастью, сказать нельзя.

Нужно ли вообще определять это понятие? Вопрос не праздный, поскольку многие ученые придерживаются мнения о том, что «информация есть информация и ничто другое и этого достаточно». Действительно, до недавнего времени слово «информация» использовалось в обыденной жизни и в практических задачах (шифровка, связь и т.д.). Там было достаточно понимание о чем идет речь на интуитивном или сугубо прикладном уровне.

В последнее время стало ясно, что информация играет в науке фундаментальную роль. Возникла потребность понять, что же это такое? Попытки связать информацию с привычными понятиями материя или энергия успехом не увенчались. Стало ясно, «информация есть информация, а не материя и не энергия». (Н.Винер [1]). Отрицание не может претендовать на роль определения, вместе с тем в данном случае оно существенно, ибо указывает на отсутствие вещественного (и/или полевого) происхождения информации. Попытки связать информацию с энтропией тоже оказались безуспешными, хотя они продолжаются до сих пор (подробнее мы это вопрос обсудим позже). Поэтому вопрос об определении понятия «информация» остается открытым.

В книге И.В. Мелик-Гайказян [2] собрана коллекция определений слова «информация», которая обсуждалась в [3], ниже мы будем следовать этим работам.

| 1.1 Определения понятия «информация |

- «информация есть знания, переданные кем-то другим или приобретенные путем собственного исследования или изучения» [4];

- «информация — это сведения, содержащиеся в данном сообщении и рассматриваемые как объект передачи, хранения и обработки» [5];

- «информация в обыденном смысле — это сведения, известия, в научно-технических приложениях — то, что имеет на себе сигнал» [6].

Наряду с этими и подобными им определениями заметна тенденция связывать информацию со степенью упорядоченности той системы, которая получает информацию:

- «информация означает порядок, коммуникация есть создание порядка из беспорядка или по крайней мере увеличение степени той упорядоченности, которая существовала до получения сообщения» [7]

Приводимые ниже определения в известной мере повторяются.

- «информация — это обозначение содержания, полученного из внешнего мира в процессе нашего приспособления к нему и приспособления к нему наших чувств» [8];

- «информация…- одно из свойств предметов, явлений, процессов объективной действительности, созданных человеком управляющих машин, заключающееся в способности воспринимать внутреннее состояние и воздействие окружающей среды и сохранять определенное время результаты его; передавать сведения о внутреннем состоянии и накопленные данные другим предметам, явлениям и процессам» [9];

- «информация — объективное содержание связи между взаимодействующими материальными объектами, проявляющееся в изменении состояний этих объектов» [10];

- «информация есть текущие данные о переменных величинах в некоей области деятельности, систематизированные сведения относительно основных причинных связей, которые содержатся в знании как понятии более общего класса, по отношению к которому информация является подчиненной» [4];

- «информация есть знание о каком-то особом событии, случае или о чем-либо подобном» [4];

- «информацией являются все те данные о внешнем мире, которые мы получаем как путем непосредственного воздействия на наши органы чувств окружающих предметов и явлений, так и опосредованным путем через книги, газеты, рассказы других людей» [11];

- «информацией называется всякое сообщение или передача сведений о чем-либо, что заранее не было известно» [12].

Среди философов популярны дефиниции, содержащие термин «отражение»:

- «информация в самом общем случае — это разнообразие, которое один объект содержит о другом, это взаимное, относительное разнообразие. С позиций теории отражения информация может быть представлена как отраженное разнообразие, как разнообразие, которое отражающий объект содержит об отраженном» [13];

- «информация есть отражение в сознании людей объективных причинно-следственных связей в окружающем нас реальном мире» [14];

- «информация — это содержание процессов отражения» [15];

- «информация не тождественна отражению, а есть лишь его инвариантная часть, поддающаяся определению, объективированию, передаче» [16].

- «информация — это философская категория, рассматриваемая наряду с такими, как пространство, время, материя. В самом общем виде информацию можно представить как сообщение, т.е. форму связи между источником, передающим сообщение и приемником, его принимающим» [17].

Определения такого типа можно суммировать в виде утверждения:

- «информация есть отражение отображения наших соображений».

Такого определения в литературе нет. По стилю оно соответствует творениям Кузьмы Пруткова (например, его миниатюре «Спор древне-греческих ученых о прекрасном»). Тем не менее, по глубине и смыслу (если кто либо попытается его в нем найти), оно не уступает приведенным выше.

В философском энциклопедическом словаре (1983 г.) приведено: «Информация (от лат. informatio — ознакомление, разъяснение, представление, понятие) 1) сообщение, осведомление о положении дел, сведения о чем-либо, передаваемые людьми; 2) уменьшаемая, снимаемая неопределенность в результате получения сообщений; 3) сообщение, неразрывно связанное с управлением, сигналы в единстве синтаксических, семантических и прагматических характеристик; 4) передача, отражение разнообразия в любых объектах и процессах (неживой и живой природы)» [18].

В «Философской энциклопедии (1970 г.) во втором томе читаем: «Информация (от латинского informatio — осведомление) — см. Теория информации [19]. А в пятом томе в статье «Теория информации» вместо дефиниций приводятся различные представления о количественной оценке информации. Дефиниции того, что собственно значит термин «информация» просто не дается. Аналогичная ситуация с перекрестными ссылками в энциклопедии описана польским сатириком Станиславом Леммом по поводу определения понятия «сепульки».

В связи с трудностями философского определения понятия «информация» возникло убеждение в том, что оно не может быть отнесено к разряду философских категорий с заменой ею отражения (П. Копнин [20].

Особое место в коллекции определений занимают утверждения о том, что информация — это алгоритм:

- «информация… есть план строения клетки и, следовательно, всего организма» [21]. Модификация этого определения содержится в работе Э. Янча,

трактовавшего информацию как «инструкцию» к самоорганизации в процессе эволюции биологических структур [22].

В работе В. Корогодина [23] приводятся определения:

- «информация есть некий алгоритм» «совокупность приемов, правил или сведений, необходимых для построения оператора, будем называть информацией». Под словом «оператор» здесь понимается некое стороннее воздействие на систему, изменяющее спонтанный ход событий.

Большое число похожих и непохожих друг на друга определений понятия «информация» означает, что общепринятого определения ещё нет. Более того, нет даже четкого понимания сути этого явления, хотя потребность в нем уже назрела.

Сейчас область применимости информационного подхода существенно расширилась. Понятие «информация» используется при исследовании практически всех процессов самоорганизации (в частности биологической эволюции). При этом актуальным становится вопрос о возниковении информации и эволюции её ценности. Здесь без определения понятий уже не обойтись.

Выбор определения зависит от аппарата исследования, иными словами, определение должно быть конструктивным, то есть пригодным для использования в рамках аппарата. Мы будем использовать аппарат теории динамических систем, поскольку именно он лежит в основе науки о самоорганизации (то есть синергетики).

Этим условиям в наибольшей степени удовлетворяет определение информации, предложенное Генри Кастлером [24].

• Информация есть случайный и запомненный выбор одного варианта из нескольких возможных и равноправных.

Здесь слово «случайный» выделено, поскольку оно относится к процессу (способу) выбора и потому сужает область применимости определения. Вообще говоря. выбор может быть и не случайным (подсказанным), в этом случае говорят о рецепции информации. Случайный выбор соответствует генерации (то есть спонтанному возникновению) информации.

Поэтому слово «случайный» мы в определении информации опустим, но учтем его при обсуждении процессов генерации и рецепции.

Слово «запомненный» тоже выделено, поскольку в дальнейшем будет играть очень важную роль. Оно относится к фиксации информации. Вообще говоря выбор может и не запоминаться (то есть тут же забываться). Такой выбор будем называть микроинформацией. Запомненный выбор (в отличие от незапоминаемого) будем называть макроинформацией .

Во всех информационных процессах используется макроинформация (запоминаемая). Микроинформация используется главным образом в теор-физических спекуляциях по поводу «демона Максвелла» (о чем пойдет речь позже).

Поэтому далее под информацией мы будем понимать только запоминаемую информацию и приставку «макро» опустим.

Слова «возможных и равноправных» означают, что варианты выбора принадлежат одному множеству и априорные различия между ними не велики. В идеале варианты могут быть полностью равноправны и равновероятны, но могут и отличаться. В этом случае слово «равноправные» означает, что априорные вероятности различных выборов — величины одного порядка.

С учетом сказанного примем определение информации в виде:

• Информация есть запомненный выбор одного

варианта из нескольких возможных и равноправных. (Q)

Далее мы будем использовать это определение и ссылаться на него как на дефиницию (Q). Мы не настаиваем на оригинальности этого определения, более того, считаем, что по духу и смыслу оно принадлежит Г. Кастлеру (откуда и обозначение: Q — Quastler)

Определение (Q) отличается от предыдущих в следующем.

- Во-первых оно четко, понятно и широко используется в естественных науках. Конструктивность его проверена на многих примерах [25-28]. Это определение не противоречит предыдущим, когда речь идет о реальных задачах. Так, определение информации как инструкции или оператора в конкретных случаях сводится к указанию, какой именно выбор следует сделать в том или ином случае.

- Во-вторых согласно этому определению информация предстаёт как нечто конкретное и «приземленное», ощущение чего-то «сверхестественного и романтического в нем отсутствует, исчезает ореол «божественного». Можно считать это недостатком определения, поскольку именно это ощущение привлекает многих людей и вдохновляет их на подвиги (научные, не научные и лже-научные).

Тем не менее, мы надеемся показать, что именно это определение позволяет понять такие тонкие явления как возникновение жизни и механизмы мышления с естественно-научной точки зрения. Иными словами — построить мост между естественными науками и гуманитарными. - В-третьих определение (Q) допускает введение меры — количества информации ( о чем пойдет речь позже).

Подчеркнем еще одну особенность определения (Q).

Слово «выбор» — отглагольное существительное. Его можно понимать в двух смыслах: как процесс и как результат процесса. Разница примерно такая же, как между судопроизводством и приговором суда. В определении Кастлера выбор понимается, как результат процесса, но не как сам процесс. Именно в этом смысле (то есть как «приговор») оно конструктивно и именно в этом смысле оно используется в реальных задачах.

Слово «процесс» в естественных науках прочно занято, оно означает изменение системы во времени (то есть «движение» её), которое в общем случае ещё не известно чекончится и кончится ли вообще. Согласно определению (Q) при этом информация еще отсутствует. Однако, информация как результат выбора не мыслима без прцесса выбора, как приговор не мыслим без суда. Отнюдь не любой процесс заканчивается выбором, Последнее возможно лишь в процессах определенного класса. Поэтому целесообразно ввести понятие «Информационный процесс», свойства которого мы обсудим позже.

В заключение этого раздела отметим, что в реальных задачах, как правило фигурирует не просто информация, а ценная или осмысленная информация (пока мы употребляем эти термины, апеллируя к интуиции читателя, определим их позже). Часто это упускают из внимания, полагая, что не ценная информация — вообще не информация. Последнее ведет к недоразумениям.

| 1.1.1. Количество информации |

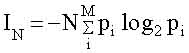

Эта величина была введена в 1948 году Клодом Шенноном [29] на примере текстового сообщения. Количество информации в сообщении, содержащем N символов IN, по Шеннону равно;

|

(1.1)

|

где M — число букв в алфавите, pi — частота встречаемости i-ой буквы в языке, на котором написано сообщение, знак » — » перед всей правой частью формулы (1.2) поставлен для того, чтобы Ii была положительной, несмотря на то, что logq pi < 0 ( pi < 1) . Двоичные логарифмы выбраны для удобства. При однократном бросании монеты М=2 («орел» или «решка»), N = 1 и pi =1/2. При этом получаем минимальное количеств информации (I=1), которое называется «бит». Иногда в (1.1) используются натуральные логарифмы. Тогда единица информации называется «нат» и связана с битом соотношением: 1 бит = 1,44 ната.

Приведенные формулы позволили определять пропускную способность каналов связи, что послужило основанием для улучшения методов кодирования и декодирования сообщений, выбора помехоустойчивых кодов, словом, для разработки основ теории связи.

В этом примере текст можно рассматривать как результат выбора определенного варианта расстановки букв.

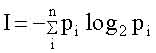

В общем случае, когда делается выбор одного варианта из n возможных (реализующихся с априорной вероятностью pi i=1,2,…n), количество информации выражается формулой:

|

; i=1,2, … n. |

(1.2)

|

Если все варианты равновероятны, то есть pi =1/n , то:

I= log2 n (1,3)

В частном случае сообщения из N букв из бинарного алфавита (М=2) число вариантов равно: n = 2N , количество информации I= N, что совпадает с формулой (1.1).

На этом примере удобно пояснить, что означает слово «равноправные» в определении (Q). Представим, что в тексте имеются символы, которые в алфавите вообще не содержатся (не «буквы»). Априорная вероятность такового считается очень малой ( pn+1 << 1/n) и в сумме (1,2) не учитывается, поскольку он выпадает из рассматриваемого множества.

Отметим, что формула (1,2) отражает количество информации, но не ценность её.

Поясним это на примере. Количество информации в сообщении, определяемое формулой Шеннона, не зависит от того или иного сочетания букв: можно сделать сообщение бессмысленным, переставив буквы. В этом случае ценность информации исчезнет, а количество информации останется прежним. Из этого примера следует, что подменять определение информации (с учетом всех её качеств) определением количества информации нельзя.

Исторически сложилось так, что определение количества информации бвло предложено раньше, чем определение самой информации. Для решения ряда практических задач это было полезно. Однако, в дальнейшем подмена понятий часто приводила к недоразумениям.

Обсудим в связи с количеством информации ещё два понятия: «Информационная тара» (термин введен В.И. Корогодиным [23]) и «Информационная ёмкость». Первый связан с мощностью множества, из которого выбираются варианты. Второй используется для физических систем, способных хранить информацию. По смыслу они близки друг другу.

Поясним смысл их на примере текста. Если любое сочетание букв в тексте является ценным, то количество ценной информации совпадает с полным количеством, но не может превышать его. Это значит, что любая передача сигналов и/или запоминающее устройство может содержать какое то количество ценной (или осмысленной) информации (не больше, чем (1,2) но может содержать и меньшее или не содержать вовсе. В этой связи количество информации в (1,2) можно назвать информационной тарой. Это понятие играет существенную роль при рецепции информации и/или при обработке её (в частности при перекодировке).

Приведем пример. Имеется текст на русском языке, содержащий Nr букв кирилицы (алфавит содержит 32 буквы). Перевод его на английский содержит Na букв латинского алфавита (26 букв). Русский текст — результат выбора определенного варианта из nr возможных (число вариантов порядка 32 в степени Nr ). Английский перевод — выбор определенного расположения латинских букв, который предопределен русским текстом (рецепция информации). Число вариантрв в английском текста порядка 26 в степени Na Количество ценной информации одинаково (если смысл не искажен), а количество информации различно.

Ниже, на примерах мы увидим, что процессы генерации, рецепции и обработки ценной информации сопровождаются «переливанием» информации из одной тары в другую. При этом, как правило. количество информации уменьшается, но количество ценной информации сохраняется. Иногда «информационные тары» столь различны. что можно говорить об информациях разного типа. Этот термин мы также будем применять к информациям, имеющим одинаковый смысл и ценность, но сильно различающихся количественно, то есть помещенных в разные тары.

В заключение раздела отметим, что сам Шеннон не разделял понятия информация и количество информации, хотя и чувствовал. что это к добру не приведет.

«Очень редко, — писал Шеннон, — удается открыть одновременно несколько тайн природы одним и тем же ключом. Здание нашего несколько искусственно созданного благополучия слишком легко может рухнуть, как только в один прекрасный день окажется, что при помощи нескольких магических слов, таких как информация, энтропия, избыточность… нельзя решить всех нерешенных проблем»[29].

| 1.1.2 Ценность информации. |

Ранее эпитеты «ценная», «осмысленная» употреблялись без определения, в расчете на интуицию. В действительности эти понятия являются центральными в современной информатике. Уместно сделать ряд замечаний.

Ценность информации зависит от цели, которую преследует рецептор.

Известны несколько способов количественного определения ценности. Все они основаны на представлении о цели, достижению которой способствует полученная информация. Чем в большей мере информация помогает достижению цели, тем более ценной она считается.

1. Если цель наверняка достижима и притом несколькими путями, то возможно определение ценности (V) по уменьшению материальных или временных затрат, благодаря использованию информации. Так, например, сочетание хороших предметного и алфавитного каталогов библиотеки, наличие библиографических справочников сокращают время на составление списка литературы по конкретному интересующему нас вопросу.

Этот метод определения ценности предложен Стратоновичем [30].

2. Если достижение цели не обязательно, но вероятно, то используется один из следующих критериев:

а) мерой ценности, предложенной М.М.Бонгартом [31] и А.А.Харкевичем [32], является:

|

V = log2 (P/p),

|

(1.3)

|

где p — вероятность достижения цели до получения информации, а P — после.

Априорная вероятность p зависит от информационной тары или. что то-же, полного количества информации I в (1,2): p = 2-I . Так, если до получения информации все варианты равновероятны, то p = 1/n (где: n — число вариантов, а I = log2 n).

Апостериорная вероятность Р может быть как больше, так и меньше р. В последнем случае ценность отрицательна и такая информация называется дезинформацией. Примером последней может служить указатель на разветвлении дорог, который по каким то причинам повернут в другую сторону. Таким образом вероятность Р находится в пределах 0 < Р <1, и, соответственно, — <V< Vmax

б) мерой ценности, предложенной В.И.Корогодиным [23], является величина

|

V = (P-p) / (1-p)

|

(1.4)

|

Она обладает теми же свойствами, что ценность (1,3), но изменяется от 0 до 1.

Мы далее будем использовать ценность, определенную в (1,4) поскольку оно удобнее и более популярно.

ii) Согласно (1.3) ценность информации зависит от величины p — вероятности достижения цели до получения информации, то есть, от того, какой предварительной (априорной) информацией он уже располагает рецептор. Предварительная осведомленность называется тезаурусом. Если таковая отсутствует, то априорная вероятность во всех вариантах одинакова и равна p=1/n (где n — число вариантов). В этом случае величина p играет роль нормировочного множителя. Если при этом, после получения информации цель достигается наверняка (P=1), то ценность этой информации максимальна и равна V= Vmax =log2 n, т.е. совпадает с максимальным количеством информации в данном множестве (в данной таре). Это совпадение не случайно, именно для этого была выбрана форма (1.3), при этом ценность информации можно понимать как количество ценной информации.

iii) Количество информации, имеющий нулевую ценность, как правило, не мало по сравнению с количеством информации, имеющих хоть какую-то ценность (положительную или отрицательную). Например: пусть цель — узнать прогноз погоды, а по радио (или телевизору) передают : кто выиграл в футбол, кто в теннис, что случилось в Санта-Барбаре и т.д. Для Вас все это имеет нулевую ценность, хотя для другого, возможно, ценна наоборот именно эта информация.

Отсюда следует, что ценность информации субъективна.

Существует информация которая , на первый взгляд, ни для кого и никогда не может стать ценной. Пример: в тексте наборщик переставил буквы так, что текст потерял всякий смысл. Количество информации сохранилось, но ценность его для кого бы то ни было, стала равна нулю.

Так появляется понятие «осмысленность». В отличие от «ценности» это понятие претендует на объективность, что основано на следующем положении: в информационной таре, куда вмещена данная информация, можно выделить определенное количество информации, которая никогда ни для кого ни для какой -либо цели не понадобится. Тогда эту информацию называют лишенной смысла. Объективность критерия основана на утверждениях : «ни для кого, никогда, ни для какой цели».

Утверждение сильное, абсолютное и, как таковое, конечно, не верное. Так, в приведенном примере можно сказать, что абракадабра, которую сотворил наборщик содержит ценную информацию для психиатора, цель которого — поставить наборщику диагноз. Поэтому утверждение «ни для кого» следует принимать: ни для кого среди людей, которых интересует смысл текста и ничего более. Однако, и в этом случае осмысленность текста зависит от тезауруса. Так, например, наборщик набрал слова «трах-тибидох-тах-тах». На первый взгляд это бессмыслица, однако, люди сведующие знают, что смысл в этих словах есть, поскольку именно с их помощью старик Хаттабыч творил чудеса.

Мы остановились на этом вопросе столь подробно по следующим причинам.

Во-первых в традиционной информатике, основанной на математической теории связи, не существует и не обсуждаются вопросы о возникновении ценной информации и ее эволюции. Ценность информации обсуждается в предположении о том, что цель задана извне. Вопрос о спонтанном возникновении цели внутри самой системы там не ставится.

Сейчас в связи с развитием науки о самоорганизации (синергетики) именно эти вопросы стали актуальными, особенно в проблеме биологической эволюции. Именно они являются предметом динамической теории информации.

При этом, как будет показано позже, ценность информации эволюционирует: не ценная информация становится ценной, бессмысленная — осмысленной и наоборот.

Во-вторых, люди невольно отождествляют просто информацию с ценной и (или осмысленной), что приводит к недоразумениям. Эта тенденция проявляется в коллекции определений информации.

Действительно, если отождествить понятия информация и ценная информация, то дать объективное и конструктивное определение такому феномену, в принципе невозможно. Напротив, разделив эти понятия, можно дать конструктивное определение каждому из них, оговорив меру условности и субъективности.

|

1.2. Рецепция и генерация информации.

|

Рецепция информации — выбор, продиктованный свыше, т.е. по указанию кого- либо или чего — либо. Иными словами, речь идет о выборе, сделанном на основании информации, которую данный человек (или система) принимает (название происходит от recept — принимать).

На языке теории динамических систем рецепция информации означает перевод системы в одно определенное состояние независимо от того, в каком состоянии она находилась раньше. В современных технических устройствах рецепция, как правило, осуществляется с помощью электрического или светового импульсов. Во всех случаях энергия импульса должна быть больше барьера между состояниями.

В теории динамических систем такое переключение за счет сторонних сил называется силовым. Наряду с ним существует и используется другой способ переключения — параметрический. Суть последнего в том, что на некоторое (конечное) время параметры системы изменяются настолько, что она становится моностабильной (то есть одно из состояний становится неустойчивым, а затем исчезает). Независимо от того, в каком состоянии находилась система, она попадает в оставшееся устойчивое состояние. После этого параметрам возвращают их прежние значения, система становится бистабильной, но остается в новом состоянии.

Параметрическое переключение, как и силовое, является рецепцией информации; отличаются лишь механизмы переключения, то есть рецепции. В современной электронике применяется преимущественно рецепция информации за счет силового переключения. В биологических системах, напротив, преимущественно используется параметрическое переключение. Последнее может быть достигнуто неспецифическими факторами (изменением температуры, рН и др.). Иными словами, неспецифические факторы могут играть роль переключателей — носителей рецептируемой информации.

Генерация информации — выбор. сделанный случайно, без подсказки извне.

В обоих случаях, как рецепции, так и генерации, способность воспринимать или генерировать зависит от информации, которую уже содержит рецептор или генератор.

В связи с этим уместно обсудить иерархию уровней информации в развивающихся системах.

|

1.2.1. Иерархия информационных уровней

|

Сперва приведем пример. Учась говорить, ребенок рецептирует информацию об языке от своего окружения, преимущественно от родителей. Овладев языком и грамотностью молодой человек оказывается перед выбором свой будущей специальности. Сделав свой выбор и овладев специальностью, человек в дальнейшем может неоднократно выбирать, в каком направлении приложить усилия. При этом новые выборы возможны только на основе прежних, более ранних, так как делаются человеком, владеющим не только языком, но и специальностью. Каждый выбор делается либо случайно, либо под влиянием внешних событий, которые часто, на первый взгляд, не относятся к делу.

Ценная информация, которой мы пользуемся повседневно и которую порой генерируем, принадлежит верхнему уровню. Для ее восприятия или генерации необходимо владеть языком (хотя бы одним) и знаниями (например, математикой, информатикой и т.д., в зависимости от профессии), т.е. обладать тезаурусом.

Каждый раз выбор делается с целью, которая ставится в данный момент, она и определяет ценность информации. Однако, все промежуточные, сиюминутные цели подчинены одной главной цели.

Какова она? Иными словами, какова цель жизни и в чем счастье?

Этим вопросам посвящены тома художественной и философской литературы. Мы тоже обсудим их, но позже, когда речь пойдет о возникновении жизни и появлению у живых существ способности к целеполаганию.

Возвращаясь к вопросу об иерархии информаций, отметим , что тезаурус — информация, содержащаяся в системе на данном уровне, необходимая для рецепции (или генерации) информации на следующем уровне.

Поясним сказанное на языке теории динамических систем. При этом придется использовать понятия и термины, смысл которых будет пояснен в следующей главе. Тем не менее. считаем это целесообразным ради слитности изложения.

В развивающейся системе необходимость выбора возникает, когда она приходит в неустойчивое состояние, т.е. находится в точке бифуркации (для определенности будем считать эту бифуркацию I-ым уровнем). Выбор делается из множества различных вариантов, мощность и характер которого определяется типом бифуркации. В простейшем случае выбор делается из двух вариантов.

После сделанного выбора система развивается устойчиво вплоть до следующей бифуркации. Здесь снова делается выбор, но уже из другого множества вариантов (II-ой уровень). Это множество зависит от результата первого выбора. Если система в своем развитии ещё не дошла до первого этапа. то вопрос о выборе варианта на втором этапе вообще теряет смысл. Иными словами, информация первого уровня является тезаурусом для второго и всех последующих уровней.

Отсюда ясно, какую роль играет тезаурус в процессе генерации ценной информации. Без него отсутствует множество, из которого надлежит сделать выбор. Выбор из любого другого множества будет иметь нулевую ценность.

Несколько сложнее обстоит дело в случае рецепции информации. В простейшем случае информация, поступающая извне, определена на том же множестве вариантов, из которого делается выбор. Именно так обстоит дело в упомянутом выше примере рецепции языка от родителей. Необходимый для этого тезаурус у ребенка присутствует от рождения.

На более высоких уровнях информация, поступающая со стороны, имеет отношение ко всем уровням, а не к данному. Тезаурус необходим для того, чтобы выделить из неё ценную информацию, относящуюся к данному уровню. Для иллюстрации этого приведем пример, (заимствован у Ю.М. Шрейдера, цитируется по [31]).

«Имеется второй том «Курса высшей математики» В.И.Смирнова. Эта книга содержит богатую информацию. Какова ее ценность? В ответ приходится спросить — для кого? Для дошкольника ценность этой информации нулевая, так как он не обладает достаточной подготовкой, достаточным уровнем рецепции и не в состоянии эту информацию воспринять. Для профессора математики ценность тоже нулевая, так как он все это хорошо знает. Максимальной ценностью эта информация обладает для студентов того курса, которым книга предназначена, — поскольку речь идет об очень хорошем учебнике».

В этом примере множество, на котором сформулирован курс высшей математики, , к уровню дошкольника не относится, поскольку он ещё не дорос до этого. Что касается профессора, то в примере Шрейдера он знает всё, и никаких целей перед собой уже не ставит. Поэтому любая информация, в том числе и учебник Смирнова, имеет для него нулевую ценность.

Особого внимания заслуживает ситуация, когда множество вариантов на следующем уровне ещё не сформировано, хотя цель уже поставлена. Именно так обстоит дело, когда речь идет об исследовании и описании нового явления. Тогда поступающая извне информация не помогает сделать выбор (поскольку выбирать ещё не из чего), но может помочь сформировать нужное множество. В упомянутом примере этому соответствует четвертый участник — ученый. В отличие от первых трех (дошкольник, студент, профессор), он не только знает учебник, но и может ставить вопросы, ответы на которые в учебниках отсутствуют. Из разговоров с коллегами и чтения книг ученый получает большое количество посторонней информации, которая относится к другим задачам. При достаточном тезаурусе ученый может рецептировать эту информацию, переработать её и сформулировать нужное множество, содержащее всего два варианта, таких, что выбор одного из них приближает к достижению цели. В науке это называется постановкой вопроса. Когда вопрос поставлен (множество сформулировано), та же посторонняя информация может помочь выбрать вариант, то есть генерировать ценную информацию. Из этого примера видно, что рецепция и генерация информации тесно связаны друг с другом. Позже мы рассмотрим этот вопрос детальнее на примере игры в рулетку.

| 1.2.2. Условная и безусловная информация |

Объект, зафиксировавший ту или иную информацию, является ее носителем. Информация, не будучи «ни материей, ни энергией», может существовать только в зафиксированном состоянии. При этом способы фиксации (записи) могут быть условными, не имеющими отношения к семантике. Отсюда возникает необходимость деления информации на условную и безусловную. Пример условной информации — код, которым пользуются, чтобы зашифровать сообщение. Кодом называется соответствие между условными символами и реальными предметами (и/или действиями). Выбор варианта кода производится случайно и запоминается как передающей, так и принимающей стороной. Ценной кодовая информация может быть только если ею владеет несколько объектов (человек), то есть эта информация связана с коллективным поведением (общественной деятельностью).

Условной является также информация, содержащаяся в алфавите и словарном запасе языка.

Кодовой является и условная генетическая информация, о которой речь пойдет в 4-ой главе. Генетику удается свести к формальному описанию явлений в терминах языка, причем весьма жесткого и закрытого. В словаре этого языка не происходит изменений, ибо любые изменения словаря приводят к летальному исходу для носителя информации. Замечательно, что в отличие от обычных языков (специалисты насчитывают 3000 различных разговорных языков!) генетический код един. Его структура одинакова как для человека, так и для растений.

Безусловной является информация о реально происходящих событиях. Она не нуждается в согласовании и может рецептироваться информационной системой даже без участия человека. Эта информация не возникает случайно, ибо она рецептируется из окружающей действительности.

Например, утверждение о том, что в такое-то время в таком-то месте произошло землетрясение является безусловной информацией. В основе самого события — случайность, выбор, но зафиксировано оно с помощью сейсмографов многими сейсмостанциями Земли вполне закономерно (приборы настроены на запись колебаний почвы). Наблюдатели узнают о событии из сейсмограмм. Рецепция события таким образом не содержит элемента случайности.

Для пояснения сказанного приведем еще один пример. Допустим, что один астроном открыл, наблюдая, новую звезду — это безусловная информация. Другой астроном ничего не открывал, но придумал для нее название — это генерация условной информации. Часто бывает так, что второй оказывается более популярен и именно ему приписывается честь открытия.

Сообщения могут содержать как условную, так и безусловную информацию, разделить их не всегда просто. Здесь играют роль следующие обстоятельства.

Первое. Условная информация имеет тенденцию к унификации, что естественно, поскольку при этом возрастают ее ценность и эффективность. Эта тенденция более выражена на нижних уровнях как эволюционно более древних. Так, например, математический формализм унифицирован на нижних уровнях иерархической информационной лестницы.

Второе. Унифицированная условная информация часто воспринимается как безусловная. Так, унифицированная на нижнем уровне математика, включающая арифметику, создает мнение о том, что «иначе не может быть». Однако унификация математического аппарата произошла в результате эволюции. При этом были в употреблении варианты, отличающиеся от современного.

На более высоких уровнях существует несколько различных вариантов описания одних и тех же объектов: континуальное описание, динамические уравнения, вероятностные модели, клеточные автоматы и т.д. Во многих случаях вопрос о предпочтении того или иного варианта остается открытым. Поэтому выбор математического аппарата — акт генерации ценной условной информации.

В принципе математика — аксиоматизированная область знаний, что делает ее единой наукой, имеющей свою логическую структуру. Идеал языка такой науки — это система правил оперирования со значками. Чтобы задать «исчисление», необходимо составить алфавит первичных элементов — знаков, задать начальные слова исчисления, построить правила получения новых слов. Математическая мысль и система кодов неразделимы. Символы имеют для математика принципиальное значение. Так, методологические установки Гильберта согласно Клини основаны на том, что символы сами по себе являются окончательными предметами и не должны использоваться для обозначения чего-либо, отличного от них самих.