Введение

Ни у кого не вызывает сомнения, что ассоциативная память человека является превосходным средством для преодоления информационной сложности, возникавшей и возникающей постоянно в процессе его жизнедеятельности. Поэтому, рассмотрение архитектуры, свойств, функциональности ассоциативной памяти человека является естественным средством моделирования способности преодоления информационной сложности. Именно ассоциативная память является тем субстратом, который подлежит всем творческим способностям человека.

Необходимо заметить, что подход к анализу информации со стороны ассоциативной памяти раскрывает одно важное отличие мозга человека от других автоматических систем обработки информации. В отличие от мозга, все существующие системы в процессе обработки информации пытаются уменьшить объем обрабатываемой информации, снять вариативность. Мозг же, наоборот, наращивает мощность представления вариантов, делая, таким образом, обработку информации все более тонкой и точной. Именно поэтому реализация нейроморфной ассоциативной памяти средствами микроэлектронной технологии в рамках проектных норм нано-диапазона, не скупящейся на объемы обрабатываемой информации, может стать единственным правильным направлением в дальнейшем развитии технологий обработки информации.

Параллельность обработки информации, реализуемая в ассоциативной памяти человека, является другим, но уже хорошо известным свойством, улучшающим возможности обработки информации. Дело в том, что массовое распараллеливание обработки приводит к отсутствию требования очень быстрой обработки (в отличие от вычислительной техники фон Неймановской архитектуры), то есть – к сравнительно невысоким тактовым частотам, а, следовательно – к малому энергопотреблению [1]. Именно в силу параллелизма обработки информации мозг потребляет сравнительно небольшие энергетические мощности.

И, наконец, обработка специфической информации в мозге приводит к формированию модели мира в виде так называемых когнитивных семантических сетей [2], которые оказываются весьма удобными при обработке (структурировании) больших объемов информации [3]. Когнитивные семантические сети возникают в мозге виртуально в процессе обработки информации на субстрате естественных нейронных сетей. При формировании такой сети ее вершины ранжируются по степени важности в рамках конкретных ситуаций, что позволяет выявлять тематическую структуру моделей предметных областей, и ассоциативно навигировать по хранилищу. Технология формирования подобных семантических представлений оказывается удобной для выявления смысла (ассоциативного соотнесения входной информации с тематической структурой модели мира) в больших массивах информации различной природы. В первую очередь, это касается обработки текстовой информации, которая в 90% случаев исчерпывает (в содержательном смысле) современные информационные потоки.

Кроме того, в процессе такой обработки, в силу ассоциативности принципов обработки, исключаются повторы в записи информации в длительном хранении, то есть, такое представление оказывается очень компактным, и легко масштабируемым, по сравнению с другими методами хранения, используемыми в традиционных видах микроэлектронной памяти.

Таким образом, нейросетевая среда (нейроморфная ассоциативная память) адекватна постановке задачи преодоления информационной сложности, в том числе, в части обработки текстовой информации. И легко позволяет реализовать поиск смысла в слабо структурированных информационных массивах.

Для подтверждения такого вывода приходится идти издалека. Поэтому, работа включает в себя следующие разделы. В основу работы положены теоретические представления о кортикоморфной ассоциативной памяти, базирующиеся на биологии и информатике коры больших полушарий и гиппокампа мозга человека. В разделе 1.1 рассмотрен прототип ассоциативной памяти – гиперколонки коры больших полушарий головного мозга человека, и пирамидные нейроны, составляющие колонки, выполняющие функции корреляции информации во входном потоке. Рассмотрены информационные свойства нейроморфной ассоциативной памяти: автоматическое структурирование больших объемов разнородной информации, запоминание информации при обучении, фильтрация запомненной ранее информации во входном потоке, автоматическое выявление повторяющихся структурных элементов различной сложности (различной частоты встречаемости) в потоке входной информации, автоматическое выявление в потоке входной информации связей структурных элементов, формирование когнитивной семантической сети. В разделе 1.2 рассмотрена обработка информации в ламелях гиппокампа – отдела мозга, ответственного за выявление степени новизны во входной информации, и переупорядочение информации, влияющее на ранжирование отдельных элементов относительно друг друга в семантической сети. В главе 2 даются представления о модели мира человека, формирующейся на основе иерархий словарей разных уровней разных модальностей в коре. В том числе, рассматривается лингвистический компонент модели мира, левополушарный схематический многомодальный компонент модели мира, а также – правополушарный образный многомодальный компонент модели мира. Показан изоморфизм лингвистической модели мира и многомодальной модели мира человека. Представлены операции на модели, связанные со сравнением и классификацией событий. В главу 3 вынесены вопросы оценки сложности модели мира в терминах объемов словарей, количества уровней, количества модальностей представления информации, а также количества тем, подтем и подподтем в тематических структурах квази-текстов. По количеству ассоциантов можно определять сложность текста в ширину. А по количеству уровней подтем у главной темы – определять сложность текста в глубину. Разработка этих вопросов предполагается быть представленной во второй (планируемой к печати) части работы под рабочим названием «Ассоциативная память – среда для формирования единого пространства знаний в процессе управления сложными процессами».

1 Прототип ассоциативной памяти – гиперколонка коры больших полушарий головного мозга человека

Под ассоциативной памятью, как и в традиционном смысле, понимается память, адресуемая по содержанию. Имеется три отличия (одно из них внутреннее, два других внешние), которые делают нейроморфную ассоциативную память непохожей на существующие до сих пор ее реализации. Внутреннее отличие заключается в нечеткости сравнения: ячейка ассоциативной памяти откликается не только на свой код, но и на похожие, в некотором смысле, коды, если этого требует задание.

Внешние отличия касаются ее эффективного применения: это не просто среда для хранения с быстрым доступом, это средство для формирования иерархической системы кластеров, составляющих модель мира, а также переранжирования контента этих кластеров в зависимости от контекста их употребления.

В мозге человека имеется две структуры, ответственные за процессы ассоциативной обработки и хранения информации, реализующих эти два процесса. В колонках коры больших полушарий головного мозга формируется и хранится иерархия словарей образов событий, появляющихся на входах сенсорных систем. Гиппокамп является структурой, которая участвует в процессе запоминания, хранения и переранжирования этих образов.

1.1 Колонка коры

Сенсорная информация поступает в кору после различных преобразований в периферии сенсорных органов в виде матрицы последовательностей, которые, каждая (информационная последовательность), поступает в свою колонку, своего уровня (нейронных переключений от входа), своей модальности [3].

В колонках коры выявляется повторяемость событий во входных последовательностях, которая позволяет сформировать иерархию словарей этих событий разной частоты встречаемости (разной степени сложности).

Колонка коры формируется, в основном, пирамидными нейронами третьего слоя, которые, будучи электронекомпактными нейронами, учитывают временную структуру информации во входных последовательностях. Они являются корреляторами [4] с нечетким сравнением, которые, будучи обучены на свой фрагмент входной последовательности (адрес) в дальнейшем реагируют на этот адрес либо строго, либо (при понижении порога чувствительности в результате внешнего управления) учитывая искажения входной последовательности. Другими словами, адреса пирамидных нейронов являются координатами точек в многомерном пространстве, то есть колонки коры моделируют фрагменты многомерного пространства, в которое отображаются в виде последовательностей сработавших нейронов входные информационные последовательности.

Ассоциативная память, таким образом, является моделью колонки коры, состоящей из множества нейроподобных элементов с временной суммацией сигналов [3]. Эти нейроподобные элементы реагируют каждый на свой n-членный фрагмент входной последовательности (адрес) и обладают пластичностью (способны запоминать количество срабатываний). Необходимо добавить, что они могут менять значения своих порогов возбуждения под воздействием управляющего воздействия, таким образом, демонстрируя в той или иной степени нечеткость сравнения.

Множество таких нейроподобных элементов обладает следующими свойствами по обработке информации. Оно реализует преобразование информационной последовательности в многомерное сигнальное пространство, обладающее рядом интересных свойств ассоциативного структурного представления информации. В первую очередь, автоматического восстановления внутренней структуры отображаемой в многомерное пространство информации: выявление словарей событий разной частоты встречаемости, а также выявление связей этих событий во входной информации.

1.1.1 Модель входного информационного потока

Сенсорные органы человека представляют собой матрицы чувствительных элементов, в той или иной степени сохраняющие топологию входной информации: мембрана улитки внутреннего уха, сетчатка глаза, поверхность кожи и подобные. Каждый чувствительный элемент, или каждая их группа, объединяющая несколько чувствительных элементов, формируют потоки информации, которые по соответствующим нервным волокнам поступают в кору, где параллельно обрабатываются. Сложность предварительной обработки в разных сенсорах у человека различна. Наиболее простой является обработка информации от поверхности кожи, сложнее – обработка слуховой информации, еще сложнее – обработка зрительной информации в сетчатке. Предмет работы в данном случае не касается предварительного анализа сенсорной информации на периферии, хотя это очень интересно, поскольку обработка очень непроста. Все, что в данный момент важно знать, это – то, что сенсорные потоки, есть множество параллельно поступающих в кору по соответствующим нервам информационных последовательностей.

1.1.2 Ассоциативность обращения к информации

Как говорилось выше, колонка коры (точнее, множество пирамидных нейронов третьего слоя коры, преимущественно формирующих колонку) моделируют своими адресами фрагменты многомерного сигнального пространства. Рассмотрим формализм обработки информации в колонках.

Пусть мы имеем n-мерное сигнальное пространство Rn и в нем единичный гиперкуб Gn ∈ Rn. Для дальнейшего изложения введем некоторые обозначения и определения.

Обозначим через G (n,N) — множество последовательностей длины N, элементы которых — точки пространства Rn, являются вершинами единичного гиперкуба Gn. В свете введенных обозначений очевидно, что G(1,N) — множество последовательностей длины N, элементами которых являются бинарные числа.

Элемент последовательности A под номером t будет обозначаться a(t), тогда через ![]() обозначим подпоследовательность последовательности A, полученную удалением из нее подряд идущих элементов с номерами от k до l включительно, в случае, когда из исходной последовательности удален только один элемент с номером k, обозначим полученную подпоследовательность A/{a(k)}.

обозначим подпоследовательность последовательности A, полученную удалением из нее подряд идущих элементов с номерами от k до l включительно, в случае, когда из исходной последовательности удален только один элемент с номером k, обозначим полученную подпоследовательность A/{a(k)}.

Траектория – последовательность Â: Â∈G(n,N)∀n, N>1 . Действительно, если последовательно соединить точки, являющиеся элементами последовательности Â, получим траекторию в пространстве Rn.

n-членный фрагмент — фрагмент длины n последовательности A∈G(1,N).

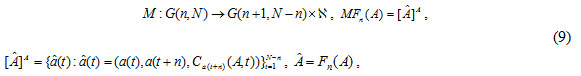

Введем преобразование (1):

Fn: G(1, N) → G(n, N+1-n), Fn(A) = Â (1)

где ![]() , то есть Â - это последовательность векторов ân в многомерном пространстве.

, то есть Â - это последовательность векторов ân в многомерном пространстве.

Введенное преобразование Fn позволяет получать траекторию в n-мерном сигнальном пространстве, координаты точек которой задаются n-членными фрагментами исходной бинарной последовательности, и является основой для структурной обработки информации. Оно обладает свойством ассоциативности обращения к точкам траектории Â по n-членному фрагменту последовательности A: любые n символов исходной последовательности A адресуют нас к соответствующей точке траектории Â. Ассоциативность преобразования (1) позволяет сохранить топологию структуры преобразуемой информации: одинаковые фрагменты входящей последовательности преобразуются в одну и ту же траекторию, разные — в разные траектории.

В общем случае входящая последовательность A может содержать одинаковые n-членные фрагменты, что приводит к возникновению точек самопересечения траектории.

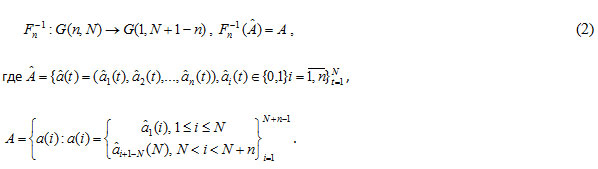

Обратное к (1) преобразование вычисляется согласно (2):

1.1.3 Авто-/гетероассоциативная запись/воспроизведение

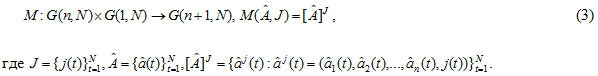

Пусть задана некоторая последовательность J ∈ G(1,N) и траектория Â ∈ G(n,N), соответствующая несущей последовательности A. Введем функцию M (3), ставящую в соответствие каждой точке траектории элемент последовательности J:

Полученную траекторию будем называть траекторией, обусловленной последовательностью J:

[Â]J = M (Fn(A),J)

Следовательно, функция M осуществляет запись последовательности J в точках траектории Â в ассоциации с последовательностью A. Назовем эту функцию функцией памяти, последовательность J — информационной или обуславливающей, последовательность A — несущей последовательностью, а такой способ записи — гетероассоциативной записью.

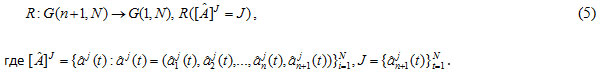

Восстановление информационной последовательности J по обусловленной ею траектории [Â]J и несущей последовательности A осуществляется с помощью функции (5):

Таким образом, имея несущую последовательность и обусловленную траекторию, с помощью функции (5) можно восстановить исходную информационную последовательность. Такой способ воспроизведения назовем гетероассоциативным воспроизведением.

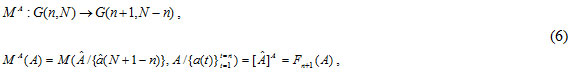

Пусть несущая последовательность A∈G(1,N). Если в качестве обуславливающей последовательности используется подпоследовательность несущей последовательности, а именно: ![]() , то имеем случай самообуславливания. Очевидно, что в этом случае обусловленная последовательность может быть получена следующим образом (здесь MA– функция памяти, модифицированная на самообуславливание):

, то имеем случай самообуславливания. Очевидно, что в этом случае обусловленная последовательность может быть получена следующим образом (здесь MA– функция памяти, модифицированная на самообуславливание):

где Â = Fn(A).

При самообуславливании восстановить информационную последовательность можно, используя (5):

![]()

Такая запись называется автоассоциативной записью, а воспроизведение – автоассоциативным воспроизведением.

Таким образом, использование функции M совместно с преобразованием Fn, обладающим свойством ассоциативного обращения к информации, позволяет реализовать ассоциативную память с возможностью авто- и гетероассоциативной записи/воспроизведения информации.

1.1.4 Функция памяти

Пусть функция памяти (3), представляет собой счетчик, фиксирующий число прохождений заданной точки траектории в заданном направлении. Очевидно, что для траектории, порожденной бинарной последовательностью согласно (1), направлений может быть не более двух. В связи с этим целесообразно ввести два счетчика, фиксирующих количество переходов заданной точки в 0 и в 1. Обозначим их C0 и C1 соответственно. Такой подход позволяет определить для заданной точки значение наиболее вероятного перехода.

Пусть задана несущая последовательность ![]() , а также порожденные этой последовательностью траектории

, а также порожденные этой последовательностью траектории ![]() и

и ![]() . Тогда счетчики C0 и C1 для t-ой точки траектории Â вычисляются следующим образом:

. Тогда счетчики C0 и C1 для t-ой точки траектории Â вычисляются следующим образом:

![]()

Модифицируем функцию автоассоциативной записи (6), используя значения счетчиков:

где ![]() — множество натуральных чисел.

— множество натуральных чисел.

Такой механизм памяти чувствителен к числу прохождений заданной точки в заданном направлении и позволяет характеризовать каждую точку траектории (за исключением последней) с точки зрения частоты появления во входной информации сочетания (â(t), a(t+n)).

Для модификации автоассоциативного воспроизведения (7) введем условие, согласно которому формируется текущий символ информационной последовательности:

Введем пороговое преобразование H с порогом h:

![]()

где Â(h) = {â(t): c(t)≥h}, N1≤N

Тогда суперпозиция HhRMFn(A) позволит выделить в сигнальном пространстве только такие точки траектории, которые были пройдены не менее h раз. Очевидно, что при h=1 Â(h) = Fn (A) = Â, т.е. будет запомнена вся информация.

1.1.5 Формирование словаря

Механизм памяти, чувствительный к числу прохождений заданной вершины в заданном направлении, является инструментом для анализа входной последовательности с точки зрения повторяющихся ее частей. Как было показано выше, одинаковые фрагменты последовательности отображаются преобразованием Fn в одну и ту же часть траектории.

Словарь формируется из множества последовательностей {Ak}, в каждой из которых с помощью суперпозиции HhRMFn (отображением последовательностей класса {Ak} в n-мерное пространство и применением к ним порогового преобразования) выделяются входящие в нее не менее h раз подпоследовательности Bj ⊂ Ak. Таким образом, преобразование HhRMFn при взаимодействии с входным множеством {Ak} генерирует словарь, характеризующий траектории, соответствующие подпоследовательностям Bj входного множества в пространстве данной мерности:

![]()

В зависимости от величины порога h преобразования H слова словаря могут быть либо цепями, либо графами.

1.1.6 Формирование синтаксической последовательности. Структурная обработка

Сформированный словарь может быть использован для детектирования старой информации в потоке новой. Для этого необходимо поглощение фрагментов входной последовательности Ã, соответствующих словам словаря, и пропускание новой, относительно словаря, информации. В результате реализуется структурный подход к обработке информации.

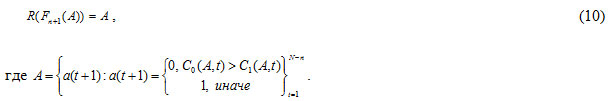

Для решения задачи детектирования преобразование Fn-1 модифицируется для придания ему детектирующих свойств. Модификация Fn,C-1 состоит в том, чтобы выделить из входной последовательности , содержащей наряду со старой информацией, на основе которой был сформирован словарь (11), некоторую новую информацию. Использование преобразования позволяет сформировать так называемую синтаксическую последовательность или последовательность аббревиатур C, характеризующую связи слов словаря {![]() } в последовательностях множества {Ak}. Обозначим через {B} множество подпоследовательностей, соответствующих всем цепям слов

} в последовательностях множества {Ak}. Обозначим через {B} множество подпоследовательностей, соответствующих всем цепям слов ![]() словаря (12):

словаря (12):

{B} = Fn-1 ({![]() }) (13)

}) (13)

Тогда

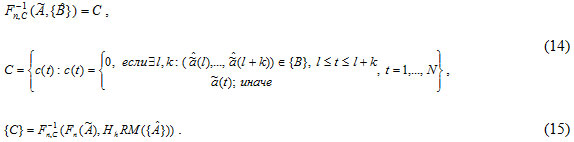

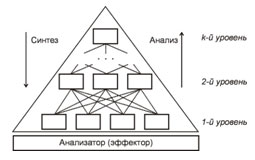

Таким образом, отображение Fn,C-1 позволяет устранить из входной последовательности Ã некоторую информацию, содержащуюся в словаре {![]() }. Тем самым создается предпосылка построения многоуровневой структуры для лингвистической (структурной) обработки входной информации. Синтаксическая последовательность C, содержащая только новую, по отношению к данному уровню, информацию, становится входной для следующего уровня. На следующем уровне, подобно описанному выше, из множества синтаксических последовательностей {C} формируется словарь и множество синтаксических последовательностей следующего уровня {E}. Итак, мы имеем стандартный элемент многоуровневой иерархической структуры (см. рис. 1). Такая обработка с выделением поуровневых словарей происходит на всех уровнях. Словарь следующего уровня является, в этом случае, грамматикой для предыдущего уровня, так как его элементами, при соответствующем выборе размерностей пространств этих уровней, являются элементы связей слов предыдущего уровня.

}. Тем самым создается предпосылка построения многоуровневой структуры для лингвистической (структурной) обработки входной информации. Синтаксическая последовательность C, содержащая только новую, по отношению к данному уровню, информацию, становится входной для следующего уровня. На следующем уровне, подобно описанному выше, из множества синтаксических последовательностей {C} формируется словарь и множество синтаксических последовательностей следующего уровня {E}. Итак, мы имеем стандартный элемент многоуровневой иерархической структуры (см. рис. 1). Такая обработка с выделением поуровневых словарей происходит на всех уровнях. Словарь следующего уровня является, в этом случае, грамматикой для предыдущего уровня, так как его элементами, при соответствующем выборе размерностей пространств этих уровней, являются элементы связей слов предыдущего уровня.

Рис. 1. Стандартный элемент многоуровневой иерархической структуры. В режиме анализа на его вход поступает множество последовательностей {A}, формирующих в нижнем уровне словарь {![]() } и на его выходе — множество синтаксических последовательностей {C}, являющихся входными для верхнего уровня. В верхнем уровне на основе множества синтаксических последовательностей {C} формируется словарь {

} и на его выходе — множество синтаксических последовательностей {C}, являющихся входными для верхнего уровня. В верхнем уровне на основе множества синтаксических последовательностей {C} формируется словарь {![]() }, а на его выходе — множество синтаксических последовательностей {E}.

}, а на его выходе — множество синтаксических последовательностей {E}.

Под распознаванием в этом случае понимается процесс принятия решения о степени совпадения входной последовательности с ранее запомненной последовательностью. В основе механизма распознавания лежит сравнение входной последовательности Ã и наиболее близкой ей, из запомненных, последовательности A, которая начинает воспроизводиться с помощью преобразования HhRMFn в ответ на входную последовательность Ã.

Под распознаванием также можно понимать процесс, реализованный на основе гетероассоциативного способа записи/воспроизведения. При обучении, в качестве несущей последовательности A используется последовательность, соответствующая запоминаемому событию, а в качестве информационной последовательности J — последовательность символов кода, соответствующего этому событию. Под распознаванием, в этом случае, понимается воспроизведение информационной последовательности J — кода события, которое инициирует входная последовательность A — реакции на входную последовательность.

1.2 Ламель гиппокампа

Другой структурой мозга, существенно важной для формирования модели мира, является гиппокамп. Ламели гиппокампа (сечения, ортогональные к длинной оси гиппокампа) ответственны за хранение информации о связях образов событий, хранящихся в колонках коры, в рамках целых ситуаций. Пирамидные нейроны (теперь уже) поля СА3 l-ой ламели гиппокампа формируют искусственную нейронную сеть Хопфилда [5], весовые характеристики которой хранят информацию об объединении образов событий хранящихся в колонках коры, относящихся к конкретной ситуации, в рамках этой ситуации.

![]()

Здесь ![]() ijkml – i-е слово (фрагмент траектории) j-го словаря k-го уровня m-ой модальности в l-ой ламели.

ijkml – i-е слово (фрагмент траектории) j-го словаря k-го уровня m-ой модальности в l-ой ламели.

Ламели гиппокампа получают информацию от колонок коры, причем и здесь работает ассоциативный принцип обращения к информации. Весь поток информации, поступающий через переключения из коры, дивергирует одновременно на все ламели гиппокампа. Но откликаются на этот поток только те ламели, которые содержат информацию о событиях, образы которых присутствуют во входном потоке. Отклик тем больше, чем ассоциация сильней, и чем больше вес образов событий в колонках коры.

При этом реализуется широкая дивергенция сигнала на поле СА3. Если в начальных звеньях гиппокампальной цепи прохождение входного сигнала узко канализировано и происходит по ламмелярному принципу, в звеньях СА3-СА1 возбуждение широко распространяется вдоль гиппокампа, связывая различные его уровни и обеспечивая возможность ассоциативных взаимодействий сигналов. В выходных проекциях гиппокампа (СА1-кора) дивергенция опять уменьшается и сравнима с дивергенцией входных путей [6].

В процессе итеративной процедуры (до 20 итераций), на каждой итерации поле СА1 гиппокампа (как конкурентная сеть) формирует отклик только одной ламели гиппокампа – наиболее близкой к входной ситуации.

Но на этом дело не кончается: в результате отклика текущей ламели, в коре, в колонке, инициировавшей процесс, происходит дообучение (в результате так называемой долговременной потенциации). И на следующей итерации ассоциативная проекция той же ситуации на ламели гиппокампа оказывается искаженной из-за дообучения, и следующий отклик ламелей изменяется.

После 15-20 итераций модель ситуации в виде образов соответствующих событий в колонке коры изменится из-за дообучения. Вообще говоря, и модель ситуаций в ламелях гиппокампа изменятся также. То есть, этот итеративный процесс переупорядочивает информацию о событиях текущей ситуации в соответствие с имеющимися моделями ситуации, хранящимися в гиппокампе, а эти модели ситуаций принимают к сведению информацию о текущей ситуации.

А поскольку поле СА3 гиппокампа работает в виде громадной автоассоциативной рекуррентной памяти по всей его длине и ширине, множество отдельных моделей ситуаций ![]() i, которые хранятся в ламелях l, совместно с образами событий, хранящихся в колонках коры, формируют единую семантическую сеть

i, которые хранятся в ламелях l, совместно с образами событий, хранящихся в колонках коры, формируют единую семантическую сеть ![]() на многомодальной модели мира, хранящейся в колонках коры.

на многомодальной модели мира, хранящейся в колонках коры.

![]()

При этом важна не дифференцировка записываемых образов, это обеспечивается в коре, а контекстуальные пространственно-временные связи образов в рамках целых ситуаций.

1.2.1 Семантическая сеть

Опишем более формально ассоциативную (однородную семантическую) сеть N, а также рассмотрим ее как некое подмножество метрического пространства.

Определение 1. Под семантической сетью N понимается множество несимметричных пар событий <<ci cj>>, где ci и cj – события, связанные между собой отношением ассоциативности (совместной встречаемости в некоторой ситуации):

N ≅ {<ci cj>} (18)

В данном случае отношение ассоциативности несимметрично: <ci cj>≠<cj ci>.

Определение 2. Семантическая сеть, описанная таким образом, может быть переописана как множество так называемых звездочек: <<ci <cj>>>:

N ≅ {zi} = {<ci <cj>>} (19)

Определение 3. Под звездочкой <ci <cj>> понимается конструкция, включающая главное событие ci, связанное с множеством событий-ассоциантов <cj>, которые являются семантическими признаками главного события, отстоящими от главного события на одну связь. Связи направлены от главного события к событиям-ассоциантам.

Определение 4. Звездочка с единичными значениями весов событий-ассоциантов называется единичной звездочкой (звездочкой-ортом).

Определение 5. Звездочкой-подпространством называется звездочка, полученная на единичной звездочке введением семантических весов событий (wj – семантические веса событий):

Z ≅ <<ci <wj cj>>>. (20)

Семантическая сеть в терминах этих определений представляет собой декартово произведение подпространств, порождаемых всеми звездочками, входящими в семантическую сеть, полученными на единичных звездочках за счет введения весовых характеристик понятий-ассоциантов:

N = Z1 x Z2 x … x ZI, (21)

Для введения в метрическом пространстве, определенном на семантической сети операций вложения и пересечения разобьем звездочки на пары событий <ci cj>. Здесь ci – главное событие звездочки, а cj ∈ <cj> — множество событий-ассоцианотов события ci. Связь направлена от ci к cj.

Все сказанное распространяется на когнитивную семантическую сеть – семантическую сеть, формируемую на нейронной сети как на субстрате [2]. В этом случае события ![]() – это квази-слова квази-словарей (образы событий), а сеть

– это квази-слова квази-словарей (образы событий), а сеть ![]() — ассоциативная сеть, построенная на образах событий в многомерном пространстве.

— ассоциативная сеть, построенная на образах событий в многомерном пространстве.

1.2.2 Перенормировка семантических весов

При формировании сети на основе большого корпуса квазитекстов, каковыми являются все входные последовательности всех модальностей, получаются корректные весовые характеристики образов событий: частота их встречаемости приближается к их смысловому весу. При анализе малых по объему квазитекстов, каковыми являются отдельные ситуации, частота встречаемости уже не характеризует важности образа события. В этом случае весовые характеристики образов событий ассоциативной сети перенормируются. При этом на каждой итерации перенормировки образы событий, связанные с образами, имеющими большой вес, свой вес увеличивают. Другие их равномерно теряют.

Сформированное первоначально статистическое представление квазитекста – сеть образов событий с их связями перенормируется с помощью итеративной процедуры, аналогичной алгоритму сети Хопфилда [5], что позволяет перейти от частотного портрета квазитекста к ассоциативной сети ключевых образов событий текста:

здесь wi(0) = zi; wij = zij / zj и ![]() — функция, нормирующая на среднее значение энергии всех вершин сети

— функция, нормирующая на среднее значение энергии всех вершин сети ![]() , где zi – частота встречаемости i-го слова в тексте, zij – частота совместной встречаемости i-го и j-го слов в фрагментах текста. Полученная числовая характеристика слов – их смысловой вес – характеризует степень их важности в тексте.

, где zi – частота встречаемости i-го слова в тексте, zij – частота совместной встречаемости i-го и j-го слов в фрагментах текста. Полученная числовая характеристика слов – их смысловой вес – характеризует степень их важности в тексте.

2 Автоматическое структурирование больших объемов разнородной информации

Используя приведенный выше формализм обработки произвольной информации, представленной в виде внутренне структурированных последовательностей (квази-текстов, и текстов, в том числе), мы можем структурировать произвольные потоки информации различных модальностей. Мы можем формировать словари образов событий разных модальностей разной частоты встречаемости (разной сложности). Мы можем формировать из входных последовательностей последовательности связей слов словарей. Таким образом, мы реализуем структурный анализ информации. Далее, мы можем формировать весовые характеристики слов этих словарей в зависимости от их смыслового (структурного) ранга в конкретных квази-текстах (в естественно-языковых текстах, в том числе). Другими словами, мы можем формировать смысловой портрет квази-текста (в том числе, и естественно-языкового текста) в виде семантической сети со взвешенными (ранжированными) вершинами.

Пользуясь этими механизмами мы можем перейти к пониманию структуры модели мира человека, которая включает в себя лингвистический и многомодальный компоненты.

И далее, мы можем сравнивать эти тексты по смыслу, вычисляя степень пересечения их семантических сетей. И, следовательно, классифицировать квази-тексты, сравнивая их смысловые портреты со смысловыми портретами классов – моделей предметных областей.

2.1 Модель мира – иерархическая структура словарей образов событий разной сложности и разных модальностей

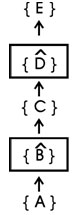

Рассмотрим формирование статического представления о мире в терминах одной модальности. Рассмотрим иерархическую структуру словарей образов событий мира, имеющую вид, представленный на рис. 2, где на каждом уровне имеется ряд словарей образов событий, связанных с образами событий следующего уровня по типу каждый с каждым. В более сложном случае – иерархическая структура может быть трехмерной (на каждом уровне состоящей из матрицы словарей).

Рис. 2. Многоуровневая иерархическая структура из словарей образов событий одной модальности, в которой на каждом уровне имеется множество словарей образов, связанных с образами словарей следующего уровня по типу «каждый-с-каждым». В каждом подсловаре {![]() i}jkm i — слово в подсловаре, j — номер подсловаря на уровне , k — номер уровня, а m — номер модальности.

i}jkm i — слово в подсловаре, j — номер подсловаря на уровне , k — номер уровня, а m — номер модальности.

События внешнего (и внутреннего) мира, отображающиеся сенсорами в иерархическую структуру данной (m-ой) сенсорной модальности, формируют в этой иерархической структуре иерархию словарей, слова которых оказываются связанными между собой синтаксическими последовательностями. При этом синтаксические последовательности, сформированные в процессе обработки предыдущего уровня, являются исходными для формирования словарей следующего уровня. Эта иерархия словарей является моделью мира в терминах m-ой модальности.

Статические знания – модель мира данной модальности – представляют собой объединение слов словарей ![]() m. На верхнем (K-ом) уровне в нем объединяются все слова

m. На верхнем (K-ом) уровне в нем объединяются все слова ![]() ilKl словаря (подсловарей) верхнего уровня, а на всех более низких уровнях – в него включается (в соответствующие места – по ассоциативному принципу) слова

ilKl словаря (подсловарей) верхнего уровня, а на всех более низких уровнях – в него включается (в соответствующие места – по ассоциативному принципу) слова ![]() ijkm словарей нижних уровней:

ijkm словарей нижних уровней:

![]() (23)

(23)

Здесь ∪ – операция объединения, ∨ - обозначает включение на свое место в слова словаря более высокого уровня. Это включение аналогично логическому сложению последовательности, соответствующей слову словаря нижнего уровня, с синтаксической последовательностью (вложению слова словаря в соответствующую купюру синтаксической последовательности).